Nederlands onderzoek behoort vaak tot de top-10 procent meest geciteerde publicaties. De Leiden Ranking vergelijkt universiteiten voor alle vakgebieden gezamenlijk; de auteurs doen dat voor het vakgebied economie. Er bestaan statistisch significante verschillen tussen de Nederlandse universiteiten, maar niet tussen de economische eenheden. De rangorde op basis van de top-10 procent meest geciteerde publicaties is negatief gecorreleerd aan die van de Institutentop van ESB, wat aangeeft dat de manier van samenstellen van een ranking mogelijk doorslaggevender is dan de kwaliteitsverschillen.

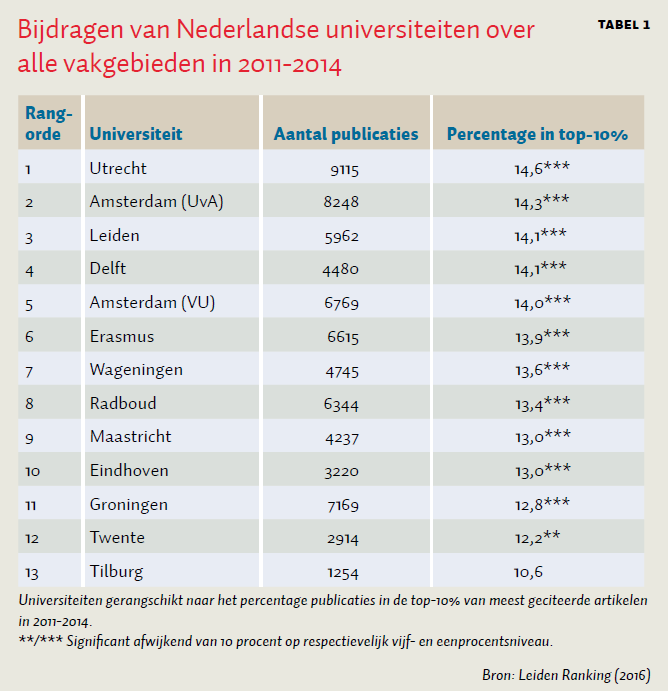

Elk jaar komen verschillende instanties met rankings van universiteiten en aan universiteiten verbonden instituten, waarbij er grote verschillen bestaan in de manier waarop prestaties gemeten worden. Onlangs publiceerde het Centrum voor Wetenschap en Technologische Studies (CWTS) de Leiden Ranking voor 2016, een ranglijst van 842 onderzoeksuniversiteiten, waaronder de 13 Nederlandse universiteiten. In tabel 1 worden de Nederlandse universiteiten gerangschikt naar de gebruikte ‘kwaliteitsindicator’ van het percentage publicaties in de top-10 procent van meest geciteerde artikelen (Waltman et al., 2012). Nederland scoort hier hoog (Leydesdorff et al., 2014).

Deze rankings zijn gebaseerd op de publicaties tussen 2011 en 2014, geïndexeerd in de Web of Science (Thomson Reuters). Anders dan de impactfactor, een voortschrijdend gemiddelde, houdt de top-10%-maat rekening met de scheve verdeling van citaties. De resultaten zijn genormaliseerd voor de vakgebieden en worden daardoor niet beïnvloed door de breedte of omvang van een universiteit.

Pieken in een hooggebergte met een enkel dal

Met de z-toets kan bepaald worden of het aantal publicaties in de top-10% significant afwijkt van wat verwacht mag worden (Leydesdorff en Bornmann, 2012). Ex ante mag worden verwacht dat tien procent van de door wetenschappers aan een universiteit gepubliceerde artikelen (na normalisering per vakgebied) tot de top-10% behoort. Bijna alle Nederlandse universiteiten scoren significant beter dan dat (p < 0,01). Twente (p < 0,05) en vooral Tilburg (niet significant) sluiten de rij. Utrecht scoort het hoogst in aantallen publicaties en top-10%-publicaties – een bijzondere prestatie. Delft, en in mindere mate Leiden, publiceert een beperkter aantal artikelen, maar scoort relatief hoog als het gaat om toppublicaties. Bij Groningen is het omgekeerde aan de orde. De correlatie tussen aantal en kwaliteit van publicaties is overigens vrijwel perfect (Spearman’s rho = 0,984; p < 0,01).

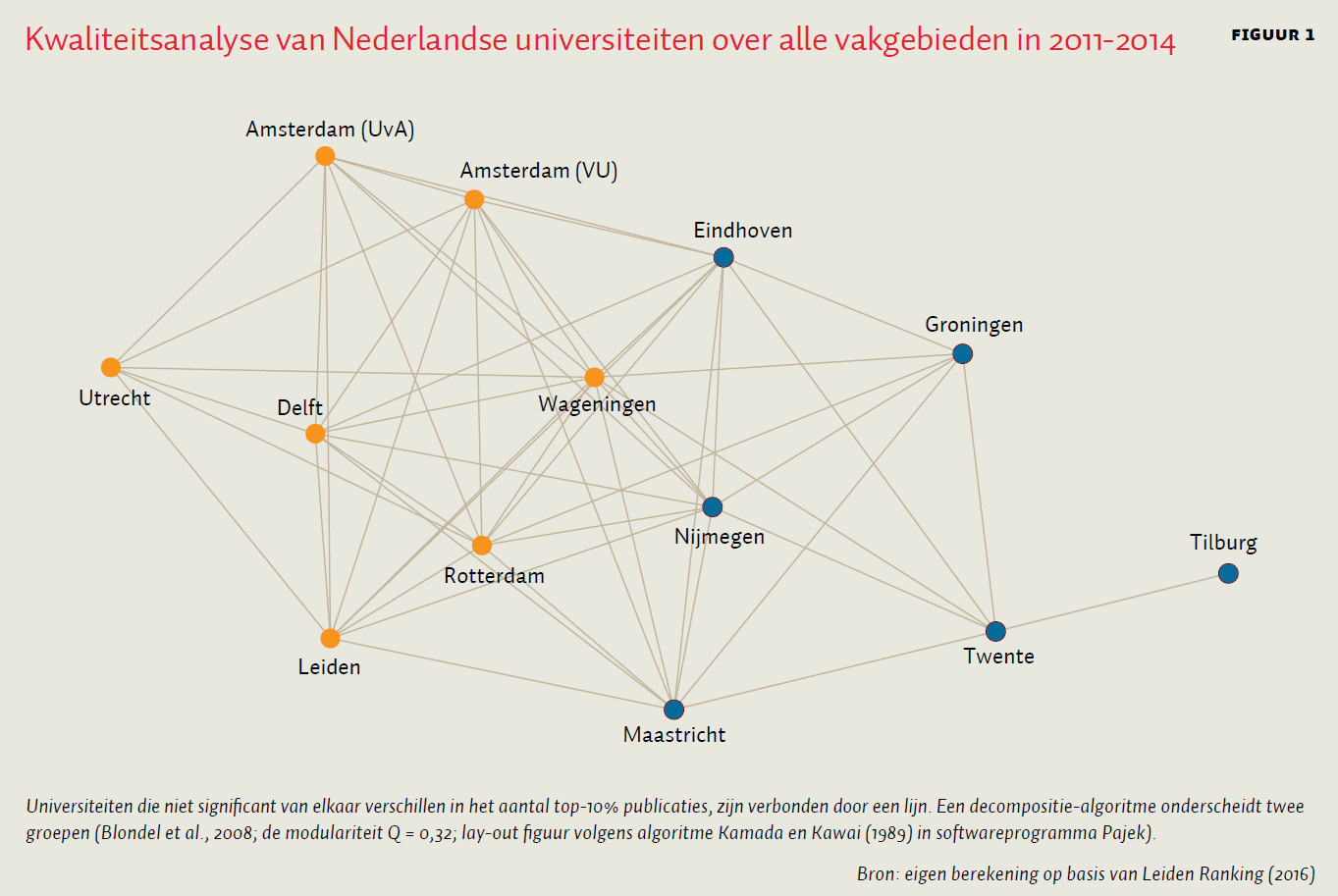

Ook kan worden getoetst of het percentage top-10%-publicaties van twee universiteiten onderling significant van elkaar verschilt. Wanneer er géén onderling verschil is, behoren universiteiten tot eenzelfde kwaliteitsgroep; wanneer er wél een significant verschil is, behoren universiteiten tot groepen van verschillende soort. In figuur 1 is dit grafisch weergegeven door universiteiten die een vergelijkbare kwaliteit hebben, met elkaar in dezelfde groep te zetten. De decompositie van het zo gegeneerde netwerk blijkt robuust bij het gebruik van verschillende algoritmes (Blondel et al., 2008; Waltman et al., 2010): de universiteiten in de Randstad inclusief Wageningen vormen één groep en de rest van het land een andere. De eerste groep scoort significant hoger op de top-10%-kwaliteitsindicator.

Voor economen is de geïsoleerde positie van Tilburg in figuur 1 opmerkelijk. Dit is mogelijk een gevolg van de vergelijking in termen van alle wetenschapsgebieden, in plaats van een vergelijking in termen van economie.

De positie van economie

Voor een inschatting van de scores van de economische eenheden aan de Nederlandse universiteiten gebruiken we de tijdschriften die Thomson Reuters in de Web of Science labelt als ‘economics’ (kader 1). Hiermee breiden we de Leiden Ranking uit. Tabel 2 toont de bijdragen aan de Web of Science-categorie ‘economics’ van de 13 Nederlandse universiteiten, gerangschikt naar het percentage publicaties in de top-10% van de meest geciteerde artikelen in 2011.

Omdat deze resultaten verrasten, herhaalden we de analyse voor 2012. Het aantal publicaties in de top-10% is ongeveer op dezelfde manier verdeeld (Spearman’s rho = 0,92; p < 0,01), hoewel er verschillen zijn. De posities van Tilburg, Nijmegen en Groningen zijn sterker in 2012 dan in 2011, terwijl Twente wegvalt in dat jaar. De rankings voor 2011 en 2012 correleren echter niet (Spearman’s rho = –0,18; n.s.), omdat het aantal citaties in de top-10% per jaar verschilt: in 2012 horen artikelen met 13 of meer citaties tot de top-10%, terwijl dit 18 is voor 2011.

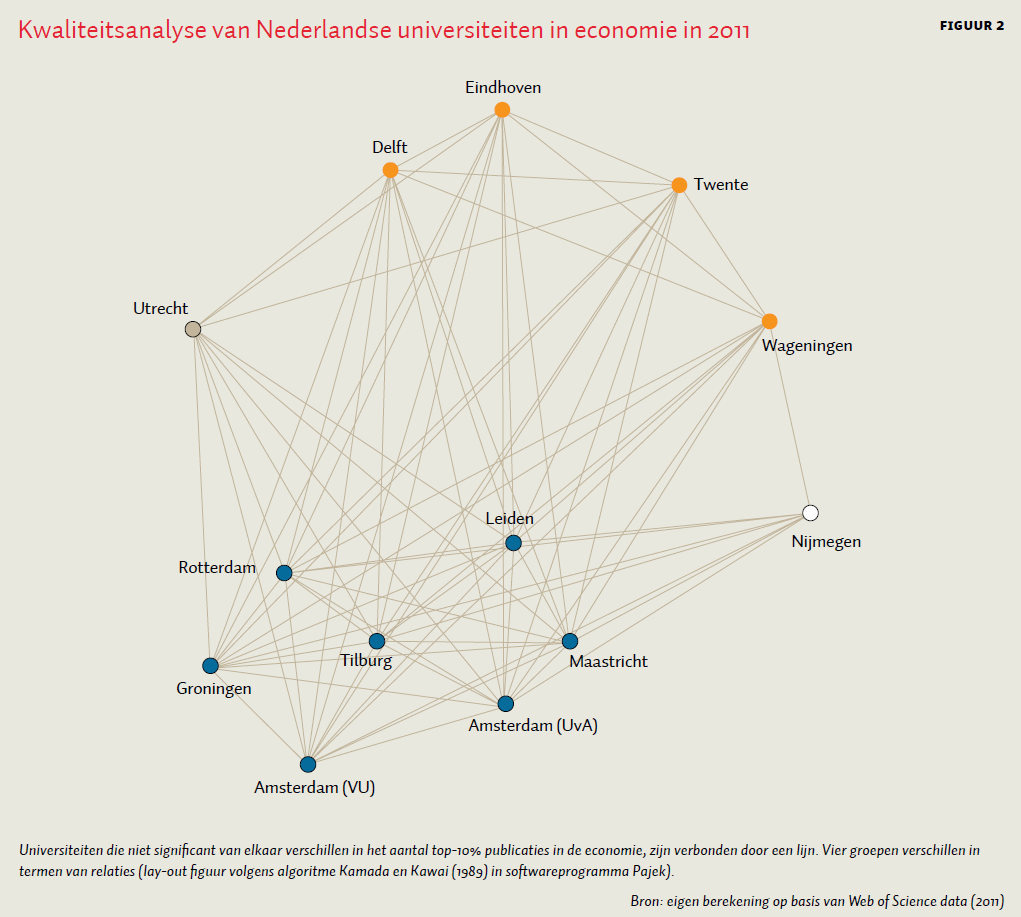

Met het nodige voorbehoud (naamvarianten, afbakening van economie) blijkt dat de geografische tweedeling voor de universiteiten in het algemeen niet van toepassing is voor de Nederlandse economie-beoefening (figuur 2). Deze blijkt daarentegen uit vier verschillende groepen te bestaan. Utrecht blijft het goed doen, anders dan in andere economie-ranglijsten. Kleine eenheden, zoals economen verbonden aan de technische universiteiten, doen het bovengemiddeld goed op deze kwaliteitsindicator. Deze kleinere eenheden kunnen binnen grotere niet-economische faculteiten in relatieve luwte floreren. Inspectie van de lijst van publicaties suggereert dat toegepast en beleidsrelevant onderzoek, zoals gericht op ecologie, het gevonden patroon deels kan verklaren. Ook kan interdisciplinair onderzoek, bijvoorbeeld op het raakvlak met geografie en engineering, rekenen op meer citaties omdat bijvoorbeeld in die velden het citatietempo hoger ligt. De traditionele economische faculteiten zien met hun grotere aantallen publicaties hun score naar het gemiddelde tenderen (met uitzondering van de VU). Nijmegen neemt een aparte positie in, significant verschillend van de technische universiteiten en Utrecht.

Kader 1: Telmethode

We gebruiken de data van de Web of Science (Thomson Reuters) voor het berekenen van de scores van economische eenheden aan Nederlandse universiteiten. De zoekopdracht ‘(wc = economics and py = 2011)’ levert wereldwijd voor economie 16.646 artikelen, reviews en letters op (op 14 juli 2016) in 350 tijdschriften. De afbakening van de top-10% ligt bij 18 citaties.

We volgen Ahlgren et al. (2014) en rekenen alle artikelen die 18 maal geciteerd zijn tot de top. We komen tot 1776 artikelen in de top. We beperken ons tot geconsolideerde namen van organisaties (bijvoorbeeld ‘Maastricht Univ’) en verwaarlozen naamvarianten (zoals ‘UNU MERIT’). Door de keuze om geen naamvarianten uit te werken, missen we in 2011 twee top-10%-publicaties van de EUR en één van Tilburg. “Tinbergen Inst” wordt zes keer met een Amsterdams adres en twee keer met een Rotterdams adres als universiteit vermeld. Deze acht papers behoren niet tot de top-10%. Eén paper van het Tinbergen instituut met een Amsterdams adres is wel gecategoriseerd als “Univ Amsterdam” en maakt deel uit van de top-10%. Anders dan bij de Leiden Ranking krijgt iedere universiteit een vol punt per publicatie, ook als er meerdere universiteiten bij de publicatie betrokken zijn.

Verschil met de Institutentop van ESB

ESB publiceert zijn eigen economen- en institutentop (Phlippen, 2015). Deze ranking is gebaseerd op lijsten van tijdschriften die door het Tinbergen Instituut en ERIM worden samengesteld en op de zogenaamde ‘article influence score’, een genormaliseerde waarde van de ‘eigenfactorscore’. Voor een volwaardige vergelijking met de hier gepresenteerde rangorde zouden de Web of Science-categorieën ‘Business’ en ‘Management’ in de beschouwing moeten worden betrokken, maar ook met de huidige data kunnen we een voorlopige vergelijking maken.

De ESB-ranking correleert negatief met die in tabel 2 (Spearman’s rho is –0,190 voor 2011 en –0,524 voor 2012). Dit laat zien dat relatief kleine verschillen in de keuzes van afgrenzingen en parameters (die nu eenmaal nodig zijn voor de normalisering) grote effecten kunnen hebben op rankings. Vergaande conclusies moeten daarom op een bredere analyse rusten.

Conclusie

Nederlandse universiteiten zijn van hoog niveau, maar er zijn opvallende verschillen te zien die niet te herleiden zijn tot hun grootte of focus. De Leiden Ranking geeft belangrijke inzichten voor Haagse en universitaire beleidsmakers. Over alle wetenschapsgebieden heen zou een ‘Universiteit van Holland’ meerwaarde kunnen hebben in termen van zichtbaarheid en het aantrekken of behouden van toponderzoekers. Het verlies aan lokale identiteit zou dan wel geaccepteerd moeten worden. Voor de overige universiteiten zou de functie in de regionale ontwikkeling bijvoorbeeld sterker aangezet kunnen worden (Vinig en Lips, 2015). Het 3TU-samenwerkingsverband is mogelijk minder zinvol: de TU Delft scoort significant hoger dan de andere twee technische universiteiten en behoort tot de elitegroep.

De conclusies die voor de Nederlandse wetenschap in het algemeen kunnen worden getrokken, blijken niet van toepassing op de economische eenheden. Hier blijken de rankings erg gevoelig voor de keuze van de parameters.

Literatuur

Ahlgren, P., O. Persson en R. Rousseau (2014) An approach for efficient online identification of the top-k percent most cited documents in large sets of Web of Science documents. ISSI Newsletter, 10(4), 81–89.

Blondel, V.D., J.L. Guillaume, R. Lambiotte en E. Lefebvre (2008) Fast unfolding of communities in large networks. Journal of Statistical Mechanics: Theory and Experiment, 8(10), 10008.

Kamada, T. en S. Kawai (1989) An algorithm for drawing general undirected graphs. Information Processing Letters, 31(1), 7–15.

Leydesdorff, L. en L. Bornmann (2012) Testing differences statistically with the Leiden Ranking. Scientometrics, 92(3), 781–783.

Leydesdorff, L., C.S. Wagner en L. Bornmann (2014) The European Union, China, and the United States in the top-1% and top-10% layers of most-frequently cited publications: competition and collaborations. Journal of Informetrics, 8(3), 606–617.

Phlippen, S. (2015) Economentop 40 2015. ESB, 100(4723 & 4724), 751–753.

Vinig, T. en D. Lips (2015) Measuring the performance of university technology transfer using meta data approach: the case of Dutch universities. Journal of Technology Transfer, 40(6), 1034–1049.

Waltman, L., N.J. van Eck en E. Noyons (2010) A unified approach to mapping and clustering of bibliometric networks. Journal of Informetrics, 4(4), 629–635.

Waltman, L., C. Calero-Medina, J. Kosten et al. (2012) The Leiden Ranking 2011/2012: data collection, indicators, and interpretation. Journal of the American Society for Information Science and Technology, 63(12), 2419–2432.